Rob˘ do Google

Algoritmo do Google: entenda como funciona e saiba como rankear em 2022

Para rankear nas primeiras posições no maior buscador do mundo, é preciso antes entender como o algoritmo do Google funciona, suas atualizações, estratégias e muito mais.

Entender o algoritmo do Google é um dos grandes desafios do SEO. Não faltam profissionais tentando desvendar o seu funcionamento. Enquanto isso, o Google guarda a sete chaves os segredos do rankeamento na SERP, a página de resultados da busca.

Por que o buscador coloca um site na primeira posição em vez de outros? Como ele faz esse julgamento? Quais fatores realmente importam para melhorar o posicionamento?

Responder essas perguntas é o caminho para as marcas traçarem as suas estratégias de otimização e ganharem mais visibilidade e tráfego orgânico nos primeiros lugares da busca.

Agora, se você também está quebrando a cabeça para responder essas perguntas, nós vamos ajudar. Neste artigo você vai ver:

- Como funciona o algoritmo do Google?

- Quais foram as principais atualizações do algoritmo do Google?

- Como conquistar o algoritmo do Google em 2020?

Acompanhe agora para saber tudo sobre o algoritmo do Google.

Como funciona o algoritmo do Google?

O algoritmo do Google é um conjunto de operações que define a forma como os resultados das buscas serão apresentados aos usuários. Para entender como ele funciona, vamos explicar como tudo começou.

Era uma vez a web. Um local inóspito, com apenas alguns sites perdidos e GIFs malfeitos. Porém, não demoraria para esse lugar ser ocupado por centenas de páginas e internautas em busca de muita informação e entretenimento.

Para facilitar a vida de quem chegava a esse novo mundo, surgiram os mecanismos de busca, com algoritmos especializados em indexar e organizar as páginas da web.

Com eles, ficou mais fácil encontrar qualquer coisa entre uma infinidade de conteúdos que começavam a povoar a internet.

Porém, não era tudo uma maravilha. Os algoritmos ainda se baseavam em fórmulas simples para o rankeamento.

Por isso, não precisava ser nenhum expert para se aproveitar deles e conquistar as melhores posições. Valia tudo para ganhar mais visibilidade e cliques! Surgia assim o black hat, o grande inimigo do Google.

Para salvar a qualidade da experiência do usuário, então, os buscadores passaram a empreender uma batalha contra os vilões da internet.

Assim, os algoritmos foram se tornando cada vez mais complexos para bloquear as más práticas e, ao mesmo tempo, valorizar os sites que entregassem os melhores resultados aos usuários.

Essa historinha dos primórdios do SEO ajuda a explicar o grande propósito do algoritmo do Google: melhorar a experiência de busca e a navegação.

É com esse objetivo que o algoritmo funciona. Ele serve para descobrir, entender e organizar todo o conteúdo da internet, a fim de entregar as melhores respostas para as pesquisas dos usuários.

Buscadores, em suma, são máquinas especializadas em responder dúvidas dos usuários. Então, o melhor resultado é aquele que traz a melhor resposta, que está não só no conteúdo que a página entrega, mas também na qualidade da experiência de navegação.

Para chegar aos resultados ideais, o Google percorre um caminho que começa muito antes de o usuário digitar sua pesquisa no buscador.

Neste vídeo, você pode ver uma explicação do Google sobre como isso acontece. Na sequência, vamos detalhar um pouco mais esse processo.

1. Rastreamento (Crawling)

Imagine vários robozinhos atrás de todo código e conteúdo que existem na internet. É isso que acontece no processo de rastreamento, que é feito a todo momento, independentemente das buscas dos usuários.

Nessa etapa, o Googlebot busca novas URLs para serem indexadas em seu enorme banco de dados. As páginas descobertas que contêm links indicam novos caminhos para que os robôs continuem o rastreamento encontrando outras URLs.

Portanto, a primeira medida de uma estratégia de SEO deve ser esta: ser encontrado pelos robôs do Google. Para isso, você precisa ter códigos e conteúdos que o Googlebot consiga ler e indexar.

O robô não consegue ler conteúdos em flash, por exemplo, o que impede que eles sejam rastreados.

Então, o desenvolvimento de sites com códigos HTML — preferencialmente simples e limpos, organizados em sitemaps — garante que seu conteúdo esteja acessível aos rastreadores.

2. Indexação (Indexing)

A indexação é o segundo passo, que também acontece a todo momento. Após o rastreamento, as URLs já podem ir para o banco de dados do buscador, que é chamado de Índice da Pesquisa.

Trata-se de uma grande biblioteca de páginas e arquivos que guarda uma infinidade de conteúdos da web.

Como, então, organizar todos esses conteúdos para que eles possam ser facilmente encontrados e acessados pelos usuários?

Durante o rastreamento, os robôs processam os dados das páginas, da mesma forma que os navegadores. Então, os servidores do Google detectam esses dados — como a idade do conteúdo, o tempo de carregamento e os textos — e registram no índice da pesquisa.

Cada página é registrada no índice para todas as palavras que ela contém. Porém, a inteligência do buscador permite que ele entenda quais são as palavras-chave mais importantes, conforme seu contexto geral, a frequência e os locais (títulos, cabeçalhos, corpo do texto etc.) em que elas aparecem. Então, esses termos funcionam como entradas para a página.

Assim, quando um usuário faz uma pesquisa, o termo de busca representa a entrada para todas as páginas que contêm aquela palavra-chave pesquisada. Quais serão exibidas e em que ordem, são os algoritmos de busca que vão definir no rankeamento.

3. Rankeamento (Ranking)

O rankeamento é o próximo passo. É aqui que o algoritmo do Google entra em ação! Aliás, o buscador usa não apenas um, mas uma série de algoritmos para fazer a classificação dos sites.

A intenção é entregar as melhores respostas ao usuário, em uma ordem que coloque os links mais relevantes nos primeiros lugares. Então, entenda que quanto mais perto do topo uma página estiver, mais relevante ela será para aquela busca.

Para isso, toda vez que um usuário faz uma pesquisa, esses algoritmos vasculham o índice e analisam vários fatores de rankeamento — estima-se que sejam mais de 200, mas o Google não revela exatamente quais são eles.

Tudo isso acontece em apenas uma fração de segundo, para que o usuário tenha as respostas o mais rápido possível.

Primeiramente, o algoritmo do Google trata de entender as pesquisas dos usuários, considerando que as palavras têm diferentes significados e que as pessoas usam uma linguagem natural na busca.

Uma atualização recente do algoritmo, chamada de BERT, tornou essa compreensão ainda mais sofisticada (mais adiante vamos falar sobre ela).

Depois, o algoritmo faz a correspondência entre o termo de busca e o conteúdo das páginas. É nesse momento que ele procura no índice as páginas indexadas para aquela palavra-chave. Quando essa correspondência ocorre, significa que a página é relevante para aquela consulta.

Então, é hora de classificar essas páginas em uma ordem que seja relevante para o usuário. Para isso, o Google procura entender se as páginas são informativas, confiáveis e de qualidade.

A análise dos elementos do site e da página, os links que recebe de outros sites e os sinais da experiência do usuário são determinantes para isso.

Esses fatores ainda recebem diferentes pesos conforme a intenção da busca. A idade de criação do conteúdo, por exemplo, é um fator muito mais relevante para pesquisas por notícias atuais do que para consultas sobre o significado de uma palavra.

Além disso, o Google exibe SERPs personalizadas. Isso significa que um site que aparece em primeiro lugar para um usuário pode não aparecer para outro, porque o rankeamento é influenciado pela localização, histórico de buscas e configurações de pesquisa de cada pessoa.

Depois de todo esse processo, o Google garante que os resultados e a ordem que são exibidos sejam relevantes para o usuário. Mas, para ter certeza disso, o buscador roda uma série de testes automatizados e ainda conta com milhares de avaliadores externos no mundo inteiro, que monitoram e julgam manualmente a qualidade dos resultados das buscas.

Embora o rastreamento e a indexação sejam essenciais, é no rankeamento que se concentra o foco do SEO. Afinal, ninguém quer ser apenas rastreado ou indexado ― a intenção do SEO é chegar nas primeiras posições do ranking!

Por esse motivo, existem várias pesquisas e estudos, como os realizados pela Moz. Eles analisam, na prática, os efeitos de determinada ação de otimização no posicionamento.

Velocidade do site, design responsivo, usabilidade, qualidade dos backlinks, taxa de cliques na SERP e tempo de permanência na página são alguns prováveis fatores de rankeamento identificados nos estudos.

Além dessas análises, algumas declarações do próprio Google e de seus funcionários também ajudam a decifrar os fatores de rankeamento. É o caso dos canais do Google e do Google Webmasters no YouTube, cheios de orientações e dicas sobre o sistema de busca.

Um documento do Google que deve ser norteador para os profissionais de SEO é o Search Quality Rater Guidelines.

Esse documento informa as diretrizes do Google para a avaliação de qualidade dos resultados da busca pelos avaliadores externos, que mencionamos antes.

Então, elas servem também como balizadoras para as estratégias de otimização, já que mostram os critérios do Google para dizer o que é uma página de qualidade.

4. Respostas úteis

Até alguns anos atrás, os sistemas de busca do Google cumpriam seu trabalho nesse ciclo de rastreamento, indexação e rankeamento.

Porém, em 2012, o buscador começou um movimento que mudou a forma de exibir os resultados da busca, o que adicionaria uma nova etapa nesse processo.

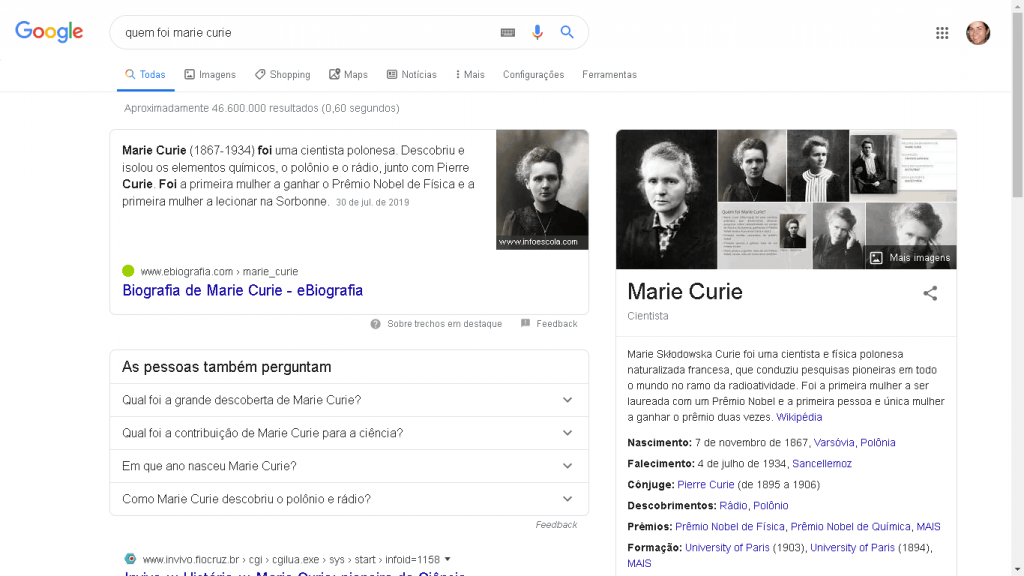

Naquele ano, era lançado o Knowledge Graph, ou Mapa de Conhecimento. Trata-se de um grande banco de dados sobre fatos e conexões que permite ao buscador entregar respostas prontas aos usuários, quando fazem perguntas como “Quem foi Marie Curie?” ou “Quando nasceu Leonardo da Vinci?”.

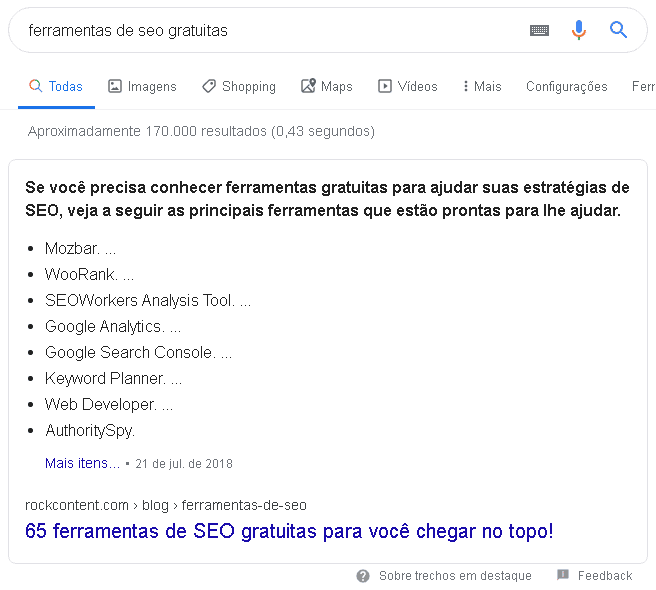

Perceba, no exemplo abaixo, que as respostas já estão na SERP — a pessoa não precisa nem ver a lista de links orgânicos ou pagos para ter a informação que deseja.

O buscador percebeu que seu papel é entender o que o usuário busca e responder aquilo que ele espera. E, muitas vezes, o que ele espera é uma resposta pronta e rápida, não uma lista de sites.

Então, com essa atualização, o Google começou a aprimorar o algoritmo para entregar respostas mais úteis e no formato ideal para o tipo de informação buscada.

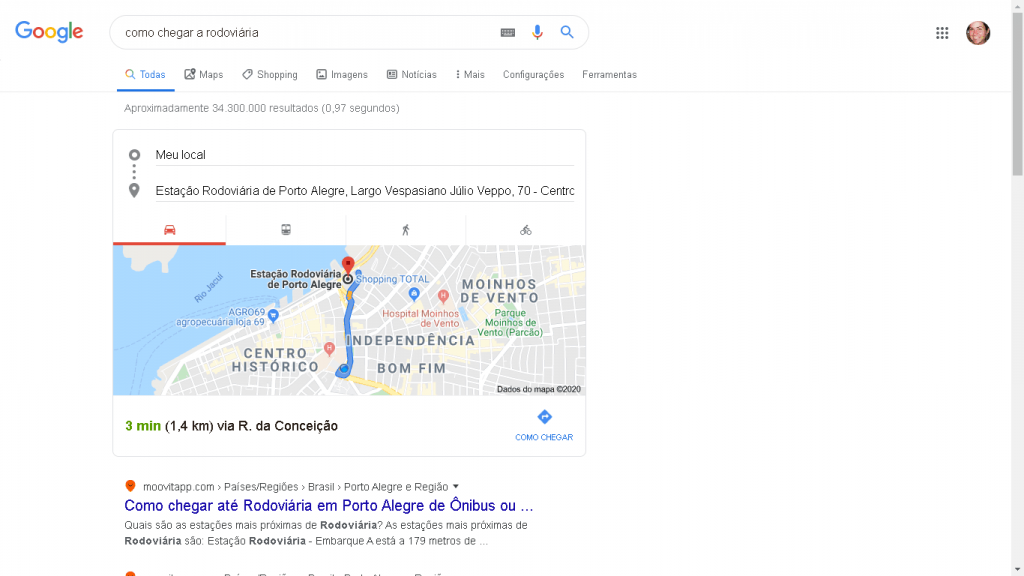

Esse é o caso das buscas por rotas e trânsito, por exemplo. Quando alguém pesquisa por “como chegar à rodoviária”, é provável que a pessoa queira ver as melhores rotas de acesso à rodoviária da cidade em que ela está.

Por isso, o Google já entrega um mapa do Google Maps na SERP, acima dos resultados orgânicos. Entregar uma lista de links, em que ela ainda teria que procurar e ler as orientações, poderia ser frustrante.

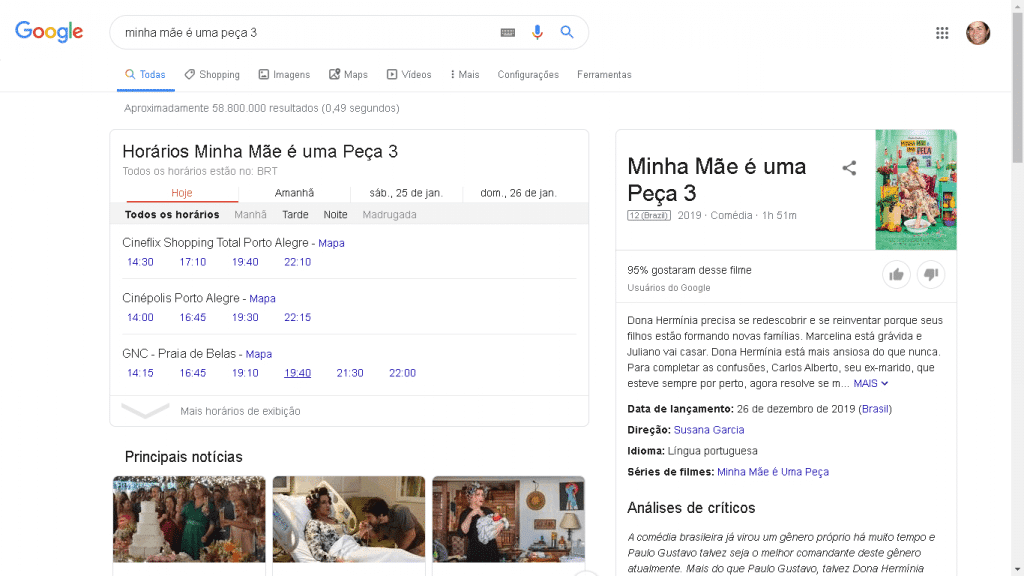

Outro exemplo é a busca por horários no cinema. Para que o usuário não precise visitar cada sala de cinema da cidade, o Google licencia as informações desses sites e oferece todos os horários já na SERP. Quando é possível, há também o link para comprar ingressos.

Além desses exemplos, existe uma infinidade de consultas que ativam as respostas rápidas do Google. E cada vez mais o buscador aprimora o algoritmo para entender as buscas dos usuários e entregar respostas úteis a eles.

Quais foram as principais atualizações do algoritmo do Google?

Ao longo da sua trajetória, o Google aprimorou o seu algoritmo sempre de olho no seu propósito: melhorar a experiência do usuário.

Apenas em 2018, a Moz contabilizou incríveis 3.234 atualizações. É por isso que os robôs mudam tanto — e o mercado de SEO precisa ficar atento.

O algoritmo se torna cada vez mais complexo e exigente. Se antes era fácil passar por cima das diretrizes do buscador, hoje ele já possui uma tecnologia inteligente o bastante para eliminar páginas que adotam práticas maliciosas.

Além de combater o black hat, a evolução do algoritmo também busca melhorar a compreensão das intenções de busca dos usuários. E é esse caminho que as atualizações mais recentes estão trilhando.

Quer saber como se dá essa evolução no algoritmo do Google? Então, acompanhe as principais atualizações dos últimos anos!

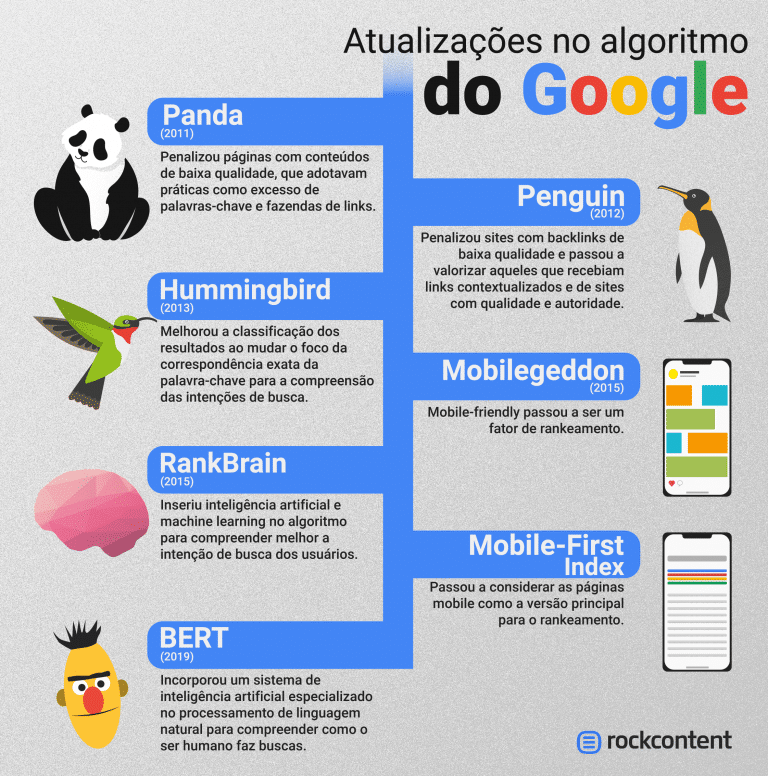

Panda (2011)

Essa foi a primeira atualização, lançada oficialmente em 2011, que impactou o mercado de SEO. Com essa atualização, 12% dos resultados da busca foram afetados e milhares de sites foram rebaixados no ranking.

O Google resolveu punir páginas com conteúdos de baixa qualidade, que incluíam práticas como estas:

- conteúdo duplicado ou copiado;

- keyword stuffing;

- textos gerados automaticamente;

- páginas com pouquíssimo ou nenhum conteúdo;

- páginas cheias de publicidade em vez de conteúdo de valor;

- “fazendas de links” para gerar mais backlinks.

Embora tenha sido lançado em 2011, várias atualizações do Panda foram feitas no decorrer dos anos e penalizaram mais sites.

Penguin (2012)

Lançado em 2012, o Penguin afetou cerca de 3% dos resultados da busca em inglês logo nos primeiros dias. Depois, ele passaria por diversas atualizações que mexeram ainda mais com a SERP.

Nesta época, o Google já estava consciente sobre a importância do SEO. Porém, a empresa queria evitar a “super otimização” dos sites, que resultava em práticas de black hat.

Por isso, o Google Penguin mirava novamente nos sites que não seguiam suas diretrizes com conteúdo de baixa qualidade, que buscava ludibriar o algoritmo.

Hummingbird (2013)

Essa atualização de 2013 foi mais focada em aprimorar os resultados de busca do que penalizar páginas e sites.

A partir do Hummingbird, as páginas não precisavam mais ter a correspondência exata da palavras-chave pesquisada pelo usuário.

Com a ajuda de sinônimos, campo semântico do termo de busca e o histórico de pesquisas do usuário, o Google já conseguia entender o que ele estava pesquisando e entregar os resultados certos.

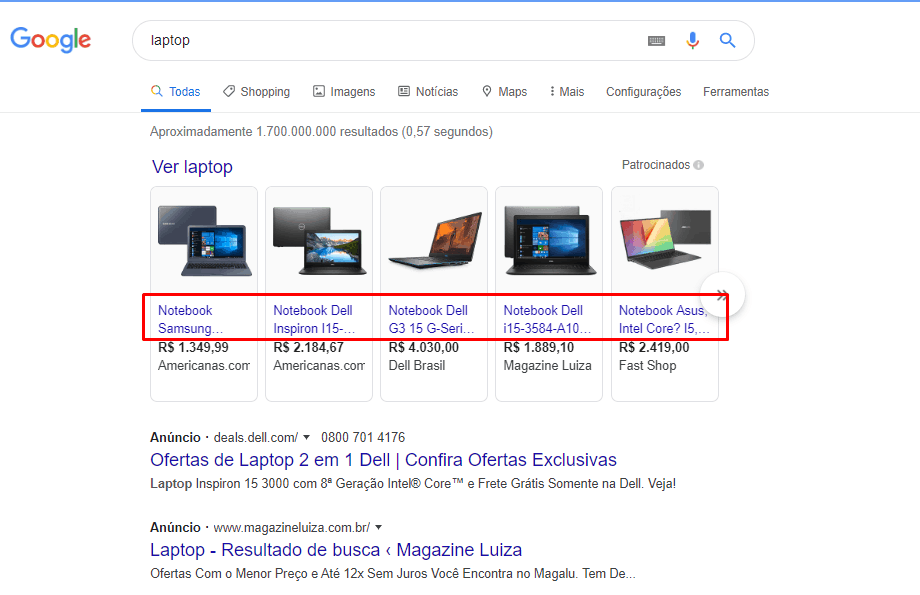

Dessa forma, uma pessoa que pesquisasse por “laptop”, por exemplo, poderia ver resultados para o termo “notebook”, se eles fossem relevantes. Isso mostra que o Google mudou o foco da palavra exata para a semântica da busca, a fim de entregar melhores respostas.

Pigeon (2014)

Essa atualização é a evolução do algoritmo para as buscas locais.

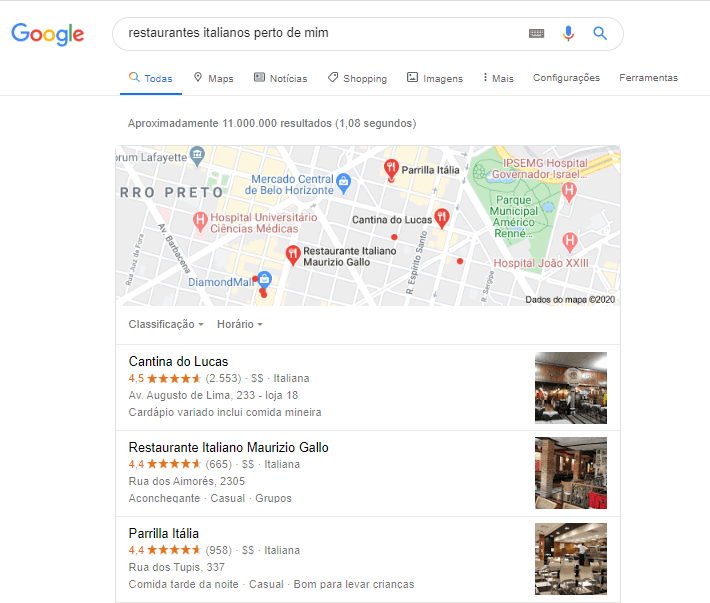

O algoritmo passou a considerar fortemente a localização do usuário na hora da pesquisa para entregar resultados de busca com negócios locais.

A busca por um restaurante, por exemplo, passou a exibir resultados próximos, dentro da cidade ou do bairro em que a pessoa estava.

Estima-se que metade dos sites decaíram na SERP, enquanto subiram páginas de pequenos negócios, que ganharam espaço com o SEO local.

Mobilegeddon (2015)

Uma grande atualização relacionada aos resultados da busca em dispositivos móveis vinha sendo anunciada. Finalmente, em 2015, o Google lançou o que o mercado esperava: o Mobilegeddon.

Com essa atualização, sites mobile-friendly passaram a ganhar mais relevância nos resultados da busca em smartphones e tablets.

A intenção era melhorar a experiência dos usuários de dispositivos móveis, que passaram a ver mais sites com design responsivo, melhor usabilidade e carregamento rápido.

Na prática, a atualização não causou tanto impacto, pois muitos sites já haviam se preparado para ela. Mas, depois, a otimização para o mobile foi ganhando ainda mais relevância com outras atualizações menores.

RankBrain (2015)

O RankBrain é uma evolução do Hummingbird. Se o algoritmo já estava mais evoluído para compreender as intenções de busca, agora ele passaria a usar inteligência artificial e machine learning para isso.

Assim, o algoritmo do Google passou a interpretar ainda melhor as consultas dos usuários. Sem a intervenção humana, ele aprende automaticamente sobre a intenção de busca e entrega resultados mais relevantes. Foi um passo gigantesco na tecnologia do buscador.

BERT (2019)

A atualização mais recente do Google, voltada para a compreensão das intenções de busca dos usuários, aconteceu em 2019 e se chama BERT.

A sigla significa Bidirectional Encoder Representations from Transformers — o que não explica muita coisa, não é? Trata-se de um novo sistema de inteligência artificial especializado no processamento de linguagem natural (Natural Language Processing ou NLP).

Segundo o Google, 15% das buscas que são realizadas todos os dias são inéditas. Ou seja, os sistemas precisam ser inteligentes suficientemente para entender todas as pesquisas dos usuários, mesmo que elas nunca tenham sido feitas antes ou que não usem as melhores palavras para descrever sua dúvida.

Por isso, o BERT é considerado uma das principais atualizações do algoritmo do Google nos últimos anos. Ele é capaz de compreender o contexto geral das buscas ao analisar as palavras que compõem uma pesquisa, os significados delas e as relações entre elas.

Portanto, não se trata mais de compreender palavras-chave específicas. O Google já consegue entender frases completas escritas com uma linguagem natural, de maneira muito próxima à forma que o ser humano compreende.

Como conquistar o algoritmo do Google em 2020?

Agora que você já conhece o algoritmo do Google mais de perto, é hora de saber como conquistá-lo de vez!

Como dissemos, os robozinhos estão se mexendo o tempo todo, e as atualizações não param. Por isso, todo ano é bom pensar quais são as principais estratégias para levar o seu site até o topo.

Agora, vamos falar das principais formas de conquistar as melhores posições do Google em 2020. Confira!

1. Otimize seu site para o EAT

Falamos antes sobre as Search Quality Rater Guidelines. Elas são as diretrizes que o Google utiliza para orientar os parceiros externos na avaliação da qualidade dos resultados da busca. Portanto, demonstram a visão do Google sobre o que é uma página de qualidade.

Neste documento, uma das principais orientações aos avaliadores é verificar o EAT de um site. Essa sigla é formada pelas iniciais das palavras:

- Expertise (nível de conhecimento) do criador do conteúdo;

- Authoritativeness (autoridade) do criador do conteúdo, do próprio conteúdo e do site em que está publicado;

- Trustworthiness (confiabilidade) do criador do conteúdo, do próprio conteúdo e do site em que está publicado.

Esses são os pilares que você deve adotar nas suas estratégias de otimização, já que o Google considera essas características essenciais para uma página de qualidade.

Quanto mais nível de conhecimento, autoridade e confiabilidade a página tiver, mais qualidade ela terá aos olhos do Google.

Uma grande preocupação atual do buscador é entregar resultados confiáveis na SERP, que tenham sido produzidos por quem domina o assunto e tenham o respaldo da comunidade na sua área de atuação. Isso é essencial diante da explosão de conteúdos na web, muitas vezes de baixa qualidade ou até de má-fé.

Esses critérios são ainda mais importantes na classificação dos sites YMYL (Your Money, Your Life), geralmente das áreas médica, jurídica ou financeira.

Esse tipo de conteúdo é sensível para os usuários, já que uma orientação errada pode colocá-lo em risco.

Mas afinal, como otimizar o seu site para o EAT? Essas diretrizes reforçam orientações básicas do SEO: oferecer conteúdo de qualidade e mostrar que você é uma referência.

Poderíamos agora listar todas as dicas de SEO que já demos por aqui. Mas vamos destacar aquelas que podem potencializar seu nível de conhecimento, autoridade e confiabilidade aos olhos do Google:

- garanta que o seu conteúdo seja produzido por quem entende do assunto e tenha uma boa reputação no mercado;

- divulgue o propósito da sua marca, quem são seus autores e por que eles devem ser confiáveis (uma página completa sobre a empresa ajuda bastante nisso);

- melhore sua reputação online com assessoria de imprensa, citações e links em sites confiáveis e avaliações positivas em sites de terceiros;

- não sobrecarregue seus usuários com anúncios que atrapalham a experiência de leitura nem tente enganá-los apenas para conseguir vender seu produto;

- cite fontes confiáveis no seu conteúdo, que tragam embasamento científico, atualizado e comprovado para o que você está falando.

Em suma, pense que o Google confia em você para melhorar a qualidade dos conteúdos que estão na internet. É nisso que você deve mirar.

2. Escreva conteúdos para pessoas

A atualização recente mais relevante do Google é o BERT, que revolucionou a compreensão da linguagem natural e das intenções de busca dos usuários. Portanto, para conquistar o algoritmo do Google em 2020, é preciso saber como otimizar seu site para o BERT.

Essa atualização do Google está tornando o algoritmo um especialista em linguagem natural. Ele já é capaz de compreender um conteúdo de forma muito parecido à do ser humano.

Isso significa que você não deve mais escrever textos para robôs nem insistir na repetição de palavras-chave. Isso não funciona mais, porque o Google não contabiliza o volume de palavras-chave, mas sim o contexto geral do conteúdo.

Sabe o que funciona, então? Escrever conteúdos para pessoas! Basicamente, é isso que você deve fazer ao otimizar suas páginas para o BERT.

Preocupe-se em criar conteúdos que sejam bons de ler, que resolvam as dúvidas das pessoas e que tragam informações relevantes, atualizadas e confiáveis.

Para isso, é importante compreender o que a sua persona está precisando e como você vai ajudá-la.

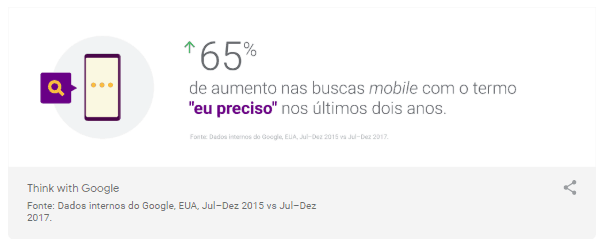

Estudos do Think With Google apontam para algumas tendências na barra de pesquisa, como a de que as buscas estão virando conversas. Pesquisas como “posso usar Paypal na Amazon” ou “que laptop eu deveria comprar” estão aumentando.

Além disso, o buscador também está se tornando um conselheiro pessoal. “Melhor seguro de carro para mim” ou “melhor restaurante perto de mim” são termos de pesquisa que mostram a intenção dos usuários de suprir suas necessidades pessoais.

No vídeo abaixo (em inglês), o gerente de pesquisas do Google ajuda a entender como as necessidades das pessoas moldam as pesquisas no buscador. São seis necessidades básicas que elas buscam resolver ao utilizar o Google:

- me surpreenda;

- me emocione;

- me impressione;

- me eduque;

- me tranquilize;

- me ajude.

Além de atender as necessidades das pessoas, seu conteúdo também deve usar uma linguagem natural, com sinônimos e palavras relacionadas ao tema principal do conteúdo, da mesma maneira que você faria se estivesse explicando o assunto a alguém.

Se o Google compreende a linguagem humana, ele vai entender o que você está falando e o que o usuário está pesquisando.

Assim, quando o algoritmo vasculhar o índice da pesquisa, sua página pode ser escolhida para entregar a resposta que o usuário busca.

3. Aprenda a lidar com as buscas sem clique

O Google está reduzindo o tráfego orgânico do seu site. Essa notícia pode assustar muita gente, mas é a consequência das mudanças do algoritmo do Google para oferecer respostas mais rápidas e úteis aos usuários.

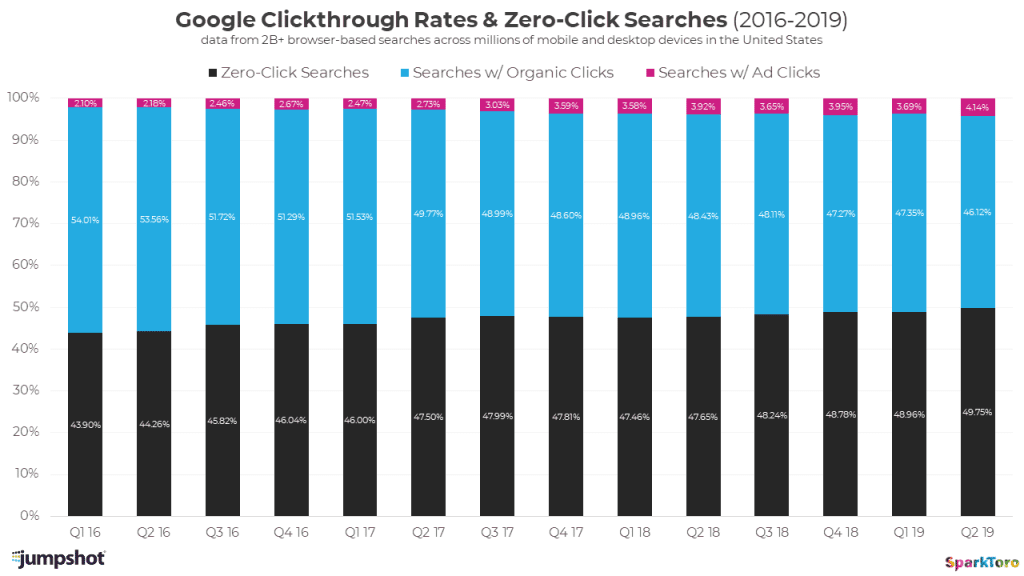

Um estudo da SparkToro mostra que muitos cliques ainda vão para os resultados orgânicos e pagos, mas que metade das buscas não gera clique algum, provavelmente porque a resposta já vem pronta na SERP.

E essa tendência vem aumentando a cada ano:

Então, como lidar com essa queda no tráfego orgânico, que sempre foi um dos objetivos primordiais do SEO?

Primeiramente, você pode adotar estratégias que ajudam a manter os acessos orgânicos ao site.

Rand Fishkin, da SparkToro, indica que a pesquisa de palavras-chave priorize os termos que têm alta taxa de cliques na SERP, não necessariamente um grande volume de buscas.

Com elas, seu site tem mais chances de receber cliques. Além disso, foque em palavras-chave de cauda longa, que geralmente não geram respostas prontas do Google.

Outra forma de lidar com as buscas sem clique é otimizar seu site para as featured snippets, que são a “posição zero” do Google. Elas aparecem acima dos resultados da busca, com um trecho retirado de uma página que entrega a resposta que o usuário busca.

Então, você pode otimizar seus conteúdos para que o Google busque essas respostas nas suas páginas.

Para isso, é importante formatar o conteúdo de acordo com os formatos que o Google utiliza para apresentar as featured snippets: parágrafos, tabelas, listas e listas numeradas.

É isso que acontece com este post do blog da Rock Content, por exemplo:

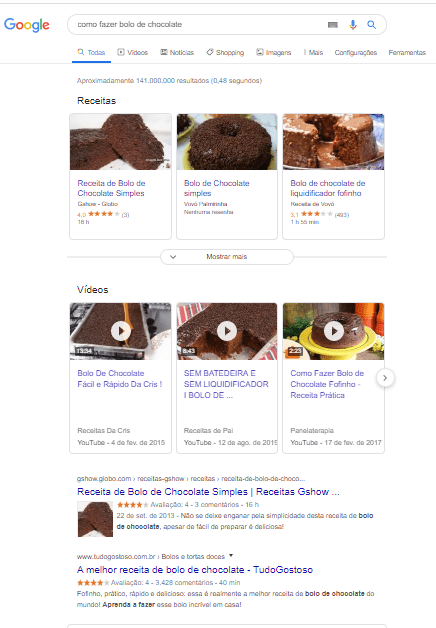

Além disso, perceba também que, para ter resultados com SEO, você não precisa necessariamente gerar tráfego. Pense, por exemplo, nos diferentes tipos de conteúdo que o Google oferece como resposta para as diferentes consultas dos usuários.

Quando eles buscam por algum assunto que seja melhor respondido por vídeos (como fazer uma receita, por exemplo), é esse formato de conteúdo que o buscador prioriza.

Então, você pode publicar conteúdos no YouTube para aparecer nessas buscas. Veja o nosso artigo sobre SEO para YouTube e veja as nossas dicas para rankear os seus vídeos.

Outro exemplo são as buscas por negócios locais. Para esse tipo de busca, o Google costuma apresentar resultados com base nos dados do Google Meu Negócio — e a lista de resultados orgânicos fica em segundo plano.

Então, você pode incluir sua empresa no Google Meu Negócio para aumentar as chances de aparecer nas buscas locais e entregar a resposta que o usuário quer (seu telefone e endereço, por exemplo), mesmo que ele não visite o seu site.

4. Otimize seu site com SEO técnico

Lembre-se sempre do grande objetivo do Google, que é oferecer a melhor experiência de busca.

Para isso, é essencial que o seu site tenha qualidade técnica, de maneira que o usuário consiga encontrar e realizar o que deseja no seu site fácil e rapidamente.

Então, o SEO técnico é a abordagem de otimização que vai ajudar você nessa tarefa. Isso engloba uma série de medidas de otimização, mas vamos agora destacar as principais.

Primeiramente, você precisa garantir que o Google possa rastrear e indexar seu site. Sem isso, nenhuma estratégia de SEO tem efeito, certo?

Para isso, é importante que você:

- envie ao Google um sitemap, que mostra todas as páginas do site que ele deve rastrear;

- monitore erros de rastreamento pelo Google Search Console que estejam impedindo suas páginas de irem para o índice do buscador;

- adote uma estrutura de site com base na arquitetura da informação, organize os seus conteúdos em subdiretórios lógicos e adote URLs amigáveis.

Essas medidas tornam a navegação do usuário mais intuitiva e facilitam que o algoritmo do Google entenda o seu site. Depois disso, foque em dois elementos essenciais do SEO técnico: responsividade e velocidade.

Desde os primeiros rumores do Mobilegeddon, a otimização para dispositivos móveis se tornou uma tendência. Mas foi o mobile-first index, lançado em 2018, que consolidou a necessidade de adotar o design responsivo para aparecer nos primeiros lugares da busca — além, é claro, de melhorar a experiência do usuário mobile.

Então, chegou a hora de você também colocar o mobile em primeiro lugar. Para isso, é preciso enfrentar uma tradição dos times de design: começar os projetos pensando na versão desktop e, depois, adaptar para o celular. Natural, já que a web começou no computador de mesa. Porém, as coisas mudaram.

O conceito de Mobile First Responsive Design é uma tendência no Marketing Digital. Essa perspectiva coloca o design responsivo em primeiro lugar nos projetos, a partir da compreensão do contexto mobile (como as buscas são feitas no celular).

Mas uma boa experiência mobile não significa apenas um design bonito e funcional no celular. Também significa velocidade.

Se no desktop a rapidez do carregamento é essencial, no celular ela se torna ainda mais importante. O contexto mostra isso: o usuário pode estar no trânsito buscando um restaurante para almoçar ou no shopping pesquisando horários de filmes. Ele precisa de uma resposta imediata!

O Google sabe disso e dedica todos os seus esforços para criar uma web mais veloz.

Uma das iniciativas mais relevantes para isso foi o projeto Accelerated Mobile Pages (AMP). Sites que adotam essa iniciativa percebem um aumento no CTR, já que os links são destacados na SERP, e oferecem um carregamento mais rápido para o usuário.

Outra iniciativa importante foi a adoção da velocidade como fator de rankeamento para as buscas mobile. Desde 2010 ela já era considerada para as pesquisas no desktop e, em julho de 2018, passou a valer também para os dispositivos móveis.

Esses movimentos mostram que o algoritmo do Google está cada vez mais exigente com a responsividade e a velocidade de carregamento.

Então, agora você já pode se preparar para dominar o algoritmo do Google em 2020!

Perceba que as tendências dos últimos anos, como velocidade e a otimização mobile, estão cada vez mais fortes. Mas entenda também que a tecnologia está sempre evoluindo e impulsionando melhorias no sistema de busca, como o processamento da linguagem natural e as respostas prontas na SERP. O seu site, então, precisa acompanhar a evolução.